Google HomeやAmazon Echo、LINE Clovaと、スマートスピーカー業界は花盛り。日本でもボイスアシスタントを使った市場が本格的に立ち上がってきています。

AIを使って「声」から人間の感情を解析できる技術「音声感情解析」を提供するのは、スタートアップ企業のEmpath社。「ICT SPRING Europe 2018」(ルクセンブルク)、「Accenture Innovation Award at GITEX 2017」(ドバイ)、「TECH IN ASIA 2018」(シンガポール)といった国際的なピッチ・コンテストで優勝するなど、熱い注目を浴びています。

声から感情を解析する技術によって、人間と人間、そして人間とロボットのコミュニケーションは今後どう変わっていくのでしょうか? CEOの下地貴明さん、CSOの山崎はずむさん、Salesの千葉美帆さんにお伺いしました。

音声を「喜び」「平常心」「怒り」「悲しみ」4つの感情で解析

「音声感情解析」とは、声の様子から話す人の感情や気分を解析するという技術です。人工知能と独自開発したアルゴリズムを使い、これをローカル環境やWeb APIを通して誰でも簡便に利用できるようにしたのがEmpath社のソフトウェア技術です。

Web Empath API(以下、 Empath)は、音声の物理的な違いを分析し、「喜び」「平常心」「怒り」「悲しみ」という人間の4つの感情に、「元気度」という指標を加え、その時々の人の感情を解析することができます。

声を吹き込むと4つの色と白の実線で感情がリアルタイムに解析される

声を吹き込むと4つの色と白の実線で感情がリアルタイムに解析される

「最近、電話によるセールスを行うコールセンターにEmpathを導入した結果、商品の購入が決定される際、お客様に表れる共通の感情があることがわかりました。なんだと思いますか?」と、千葉さん。

欲しい物を買うのだから、「喜び」のようなポジティブな感情が出ると誰もが予測しそうですが、実際には「悲しみ」の感情が表れたそうです。

「その理由をひもといてみると、決断の瞬間は多かれ少なかれ誰しも“悩み”や“迷い”があるからではないかと推察できました。悩んでいるときや迷っているときには眉間にしわを寄せたりしますよね。そういった感情が声の解析から読み取れたのです。これは意外な発見でした」(千葉さん)

左から山崎はずむさん、千葉美帆さん、下地貴明さん

左から山崎はずむさん、千葉美帆さん、下地貴明さん

Empathを導入したコールセンターでは、この「悲しみ」の感情が表れたタイミングでオペレーターが適切な声をかけることで、成約率を20%アップさせたそうです。

「顧客の声から購入意思に結びつくトリガーがはっきりわかったのは、大きな収穫でした」(千葉さん)

声に含まれる「気持ち」の見える化が可能になると、例えばコールセンターであれば、お客様に「悲しみ」の感情が現れたときに購入決断のひと押しをしてあげることで、セールスに結びつけることができます。このようにEmpathのような感情解析エンジンのボイスコマースへの活用が、現実味を増しています。

「当初は、声を可視化することで、コールセンターにおけるスタッフのメンタルヘルス支援に役立つのではないか、という利用用途を想定していました。実際に、Empathでオペレーターの声を分析したところ『元気度』が高いオペレーターさんは成約率が高いことや、『悲しみ』が多く出たスタッフは離職率が高くなるためケアするなど、感情解析をもと職場の改善を働きかけられるようになってきています」(千葉さん)

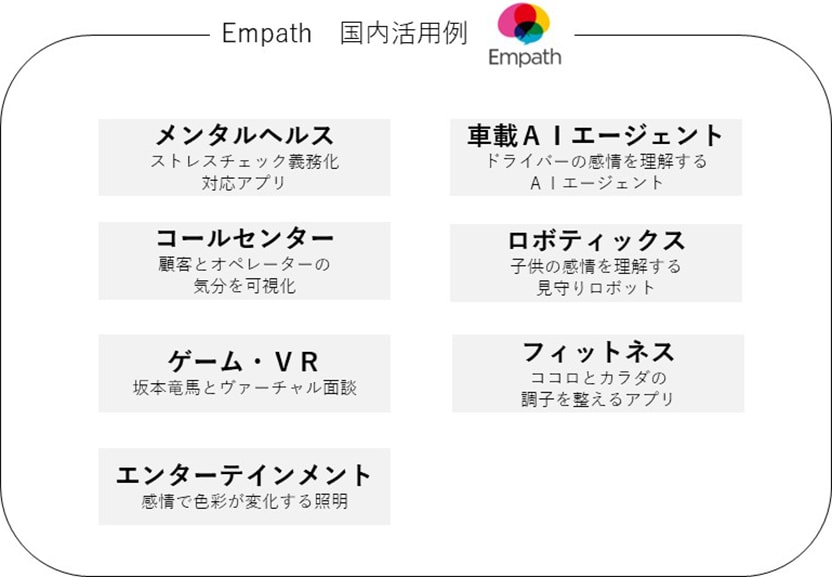

Empathの技術は50ヶ国以上の企業で導入され、コールセンターでの活用のほか、エンターテイメント分野、ロボティックス、メンタルヘルスなど、様々な分野で活用されている

Empathの技術は50ヶ国以上の企業で導入され、コールセンターでの活用のほか、エンターテイメント分野、ロボティックス、メンタルヘルスなど、様々な分野で活用されている

もともと、Empathが生まれたきっかけは、東日本大震災のボランティアのケアに向けたメンタルヘルス管理ツールだったそうです。

「NTTドコモとの協業で、東日本大震災における被災地支援のプロジェクトに参加し、2013年の3月から約1年、ボランティアさんの感情を声から診断するということを行いました。ボランティアさんに毎日“おはよう”と声をかけていただくことで音声データをとり、悲しみや元気度が落ちるなどの兆しが出た際は早めにカウンセリングを受けてもらいました。その結果、一人も辞める人を出すことなくプロジェクトを終えられました」(千葉さん)

音声解析で人の気持ちを理解し、もっと社会をよくしていきたいということは、Empathの当初からのビジョンでもあります。

「感情は目に見えないため人間同士ですれ違いが起こることが多々あります。我々のミッションは、それを見える化することで、人と人、さらには人とロボットがうまくつながれる世界にしていくということです」(下地さん)

注目されるスマートスピーカーとのマッチング

利用分野も多様な「音声感情解析」ですが、現在もっとも期待されるのがスマートスピーカーとのマッチングです。Empath社では、すでにGoogle社、Amazon社の関連セクションと、スマートスピーカーとの親和性について意見交換を行っているそうです。

「現在の音声アシスタント技術は、目的が明確ならば9割程度の正確さで人の声による指示を読み取って動作し、発音や抑揚も人間と変わらないところまできています。ただ、より適切な応答ができるようになるためには、もっと人間の気持ちを理解することが重要になってきます。Google社にも、共感とは何か、AIが人間に寄り添った対応をするにはどうすればいいかなどを研究する部署があるほどです。

では、気持ちを読み取るにはどうするか。もちろん会話(言葉)そのものを解析することはできますが、人間は、“元気だよ”とか“大丈夫だよ”と言葉では表現しても、本心は異なっているときがあります。現在は言語解析優位で額面通りに返答しますが、声に『悲しみ』や『怒り』が含まれていたら、その感情に寄り添った違う返答をさせることもできるのではないでしょうか」(山崎さん)

「実際、Empathは言葉の意味内容ではなく、声の調子——ピッチやスピード、語気の強さといったもの——を読み取っています。またこれには、言語に関係なく対応できるというメリットもあります。厳密には文化差や言語差はありますが、すでに弊社が公開するAPIを通じて多言語の音声データを十分収集し、強化学習を行っているため、汎用データとしては、国や言葉の違いを超えて実用できるものとなっています」(下地さん)

現在の音声アシスタントは、まだふつうの会話ができるレベルではありません。ですが、人間の気持ちを正確に読み取って、本物のコンパニオンのような存在になるのも、そう遠い未来ではなさそうです。

「会話で終わらせず、“今日は○○さんは元気そうですね!こんなイベントに行かれてみてはどうですか?”というように、相手の状態に合わせて適切なレコメンデーションをすることも可能でしょう。音声解析を組み込むことでボイスコマースの成約率向上も期待できると考えています」(下地さん)

どう実装されていくかはスマートスピーカー各社次第ですが、音声解析に対する経済効果の伸びしろが約14兆円あるといわれるなか、さらにボイスコマースの経済効果が加わればと考えると、Empathがいかに多くの可能性を秘めているかがわかります。

WebキャンペーンからMRを使った未来の利用まで

メンタルヘルス支援やコールセンターのほか、ロボット関連では、クルマの車載エージェント、介護ロボット、さらには声の様子から会議がどれだけ生産的に進められているか判断するなど、人事的な面からの引き合いもあるという音声感情解析の技術。もちろん、Webキャンペーンなどプロモーションにも活用の可能性はあるといいます。

「昨年の夏から、iOSでもスマートフォンのWebブラウザ上のアプリでも音声録音ができるようになったこともあり、Webプロモーションでの導入の可能性がますます広がっていますね。しかし、ただ声から感情を計測できるというシステムだけでは、人の興味を引くものにはなり得ません。分析で可視化された『喜び』『平常心』『怒り』『悲しみ』といった4つの感情要素を生かして、そこからどのようにアウトプットしていくのか、しっかりと設計をしてプロモーション企画に仕立てる必要があります」(下地さん)

MINTIA EXCAREのキャンペーンでの導入事例。声によって様々なキャラクターが生まれる

MINTIA EXCAREのキャンペーンでの導入事例。声によって様々なキャラクターが生まれる

※制作/面白法人カヤック

最後に、音声感情分析技術と密接に関わる、音声によるインターフェースの可能性について伺いました。

「現在、スマートスピーカーは音声同士のコミュニケーションですが、AmazonではすでにEcho SpotやEcho Showなどディスプレイ付き商品が出ており、ビジュアルも組み合わせたデバイスが今後増えるでしょう。ECに関しては、やはり商品の品定めは目で見て判断するほうが早いので、視覚情報は必須になると思います。さらに注目されているMR(Mixed Reality)では、声で質問しながら、ホログラフィーで商品を閲覧、手やジェスチャーで商品を選ぶという複合的なインターフェースも登場しそうです。

インプット技術としては、キーボードより声のほうが自然かもしれませんよね。さらに進んでブレイン・コンピュータによって脳からいきなり発信するようなものも考えられていますが、実用は当分先といわれています。それまで、音声によるコントロールやインプットの分野は、どんどん拡大していくと考えています」(下地さん)

人は感情で行動する、といわれるように、感情と行動には密接な関係性があるとされています。この目には見えない感情を可視化する音声感情解析技術は、人の行動を促進するためのアプローチを変えるといったビジネス活用だけでなく、コミュニケーションの質そのものを高める技術として生活シーンにおいても活用が拡がっていきそうです。

- Written by:

- BAE編集部